„Papież Franciszek szokuje świat, popiera Donalda Trumpa na prezydenta”. „Asystent Clintona, JW McGill, zostaje znaleziony martwy.” „„ Dziesiątki tysięcy ”fałszywych głosów Clintona znalezionych w magazynie w Ohio. Te szokujące nagłówki wiadomości z ubiegłego roku łączyły jedno: nie były prawdziwe. Nie jest w najmniejszym stopniu. Każda z nich została wyprodukowana ze złej woli lub z zamiarem zarobienia dochodów z reklam, aby oszukać jak najwięcej nieświadomych czytelników Internetu. Innymi słowy, były to „fałszywe wiadomości”.

powiązana zawartość

- Walka z nazistami za pomocą fałszywych wiadomości

- Fałszywy program radiowy w Wielkiej Brytanii, który pomógł pokonać nazistów

- Remedium na rozprzestrzenianie się fałszywych wiadomości? Nauczyciele historii

Fałszywe wiadomości oczywiście nie są niczym nowym. W przeszłości przybierało formę broszur tworzonych w celu wymazania wrogów politycznych lub sensacyjnych opowieści zaprojektowanych w celu „zarażenia” staromodną drogą sprzedaży gazet. Jednak niedawny przypływ fałszywych informacji, które umożliwiają nam nowe krajobrazy w mediach społecznościowych, popchnął je do przodu jako poważny problem warty debaty krajowej, a nawet międzynarodowej.

Ludzie mówią, że problemem jest medium. Co ma sens: platformy mediów społecznościowych, takie jak Facebook, są krytykowane za umożliwienie rozpowszechniania tego rodzaju wprowadzających w błąd lub niepoprawnych informacji, ponieważ pozwalają każdemu użytkownikowi lub nawet zautomatyzowanemu botowi na publikowanie legalnie wyglądających artykułów, które następnie rozprzestrzeniają się jak pożar poprzez „polubienie” ”i„ udostępnianie ”. Teraz Facebook wprowadził nowe narzędzia do zwalczania fałszywych artykułów wirusowych, podczas gdy Twitter testuje nową funkcję pozwalającą użytkownikom oznaczać wprowadzające w błąd, fałszywe lub szkodliwe informacje.

Ale nowe badanie opublikowane w tym tygodniu w czasopiśmie Nature Human Behaviour pokazuje, że winne są również ograniczenia ludzkiego mózgu. Badanie sugeruje, że kiedy ludzie są przepełnieni nowymi informacjami, polegają na mniej niż idealnych mechanizmach radzenia sobie, aby odróżnić dobro od zła i ostatecznie uprzywilejować popularność nad jakością. To śmiertelna kombinacja nasycenia danych i krótkich, rozciągniętych okresów uwagi, które mogą umożliwić skuteczne rozpowszechnianie fałszywych wiadomości.

„Poprzez sieci takie jak Twitter i Facebook użytkownicy są codziennie narażeni na dużą liczbę przekazywalnych informacji, które konkurują o sukces”, mówi Diego Fregolente Mendes de Oliveira, fizyk z Northwestern University, który bada, w jaki sposób działają sieci ludzi i prowadzą autor opracowania.

Oliveira mówi, że ze względu na znaczący wpływ mediów społecznościowych na politykę i życie, rozróżnianie między dobrymi a złymi informacjami stało się „ważniejsze w dzisiejszych internetowych sieciach informacyjnych niż kiedykolwiek wcześniej”. Mimo że stawki są wyższe, dynamika podobnie myślących grup, takich jak te znalezione w mediach społecznościowych, może podważyć zbiorowy osąd tych grup - czyniąc wezwania do oceny fałszywych wiadomości jeszcze trudniejszymi. Jak ujęto w badaniu, przy zbyt dużej ilości informacji ludzie stają się „podatni na manipulacje”.

W 2016 r. Oliveira postanowiła zbadać, w jaki sposób informacje rozprzestrzeniają się w sieciach społecznościowych, aw szczególności, w jaki sposób „informacje niskiej jakości” lub fałszywe wiadomości mogą skończyć falą jak zaraźliwość. Zaprojektował model teoretyczny, aby przewidzieć, w jaki sposób fałszywe wiadomości rozprzestrzeniają się w sieciach społecznościowych.

W modelu nie uwzględniono rzeczywistych użytkowników ani fałszywych artykułów. Ale wykorzystał dane zebrane przez niezależnych obserwatorów o zdemaskowanych (ale mimo to popularnych) artykułach na Facebooku i Twitterze, aby obliczyć średni stosunek prawdziwych wiadomości do fałszywych wiadomości w postach oznaczonych do oceny przez użytkowników. Oliveira wykorzystał ten współczynnik do uruchomienia zaprojektowanego przez siebie algorytmu udostępniania wiadomości w sieci.

Model ten był podobny do poprzedniego badania, w którym Oliveira pokazał, w jaki sposób ludzie, którzy dzielą się na osobne sieci - na przykład bańki społecznościowe podobnie myślących osób, które tworzy się na Facebooku - mogą przyczynić się do mistyfikacji i rozpowszechniania fałszywych informacji. W miarę myślenia ludzie ci są mniej narażeni na informacje sprzeczne z postami, którymi dzielą się ich podobnie myślący przyjaciele, którzy mogą wyprzeć fałszywe wiadomości i ujawnić prawdę.

Przy stosunkowo niskim przepływie informacji jego algorytm przewidywał, że teoretyczny użytkownik mediów społecznościowych był w stanie dobrze rozróżnić prawdziwe i fałszywe wiadomości, dzieląc się głównie prawdziwymi wiadomościami. Jednak gdy Oliveira i jego współautorzy poprawili algorytm, aby odzwierciedlić coraz większy przepływ informacji - odpowiednik przewijania niekończącego się kanału na Twitterze lub Facebooku - teoretyczny użytkownik coraz mniej potrafił sortować informacje jakościowe od złych informacji.

Oliveira odkryła, że ogólnie popularność miała silniejszy wpływ na to, czy dana osoba dzieli coś innego niż jakość. Przy wyższych poziomach przepływu informacji efekt ten stał się bardziej wyraźny, co oznacza, że ludzie teoretycznie spędziliby mniej lub wcale nie oceniali jakości informacji przed podjęciem decyzji o udostępnieniu. Wkrótce, gdy coraz mniej zwracali uwagę na każdą informację, ludzie dzielili się fałszywymi wiadomościami w coraz większym tempie.

Przy najwyższych modelowanych stawkach jakość informacji nie miała wpływu na popularność tej informacji. „Pokazujemy, że zarówno przeciążenie informacjami, jak i ograniczona uwaga przyczyniają się do pogorszenia mocy dyskryminacyjnej systemu”, powiedział Oliveira za pośrednictwem poczty elektronicznej.

Chociaż model ma wyraźne ograniczenia, zapewnia jedną interpretację rozpowszechniania fałszywych wiadomości. „Tradycyjnie uważa się, że prawda ma pewną nieodłączną moc do przezwyciężenia fałszu” - mówi Haluk Bingol, inżynier komputerowy na Uniwersytecie Boğaziçi w Turcji, który od dawna studiuje sieci internetowe. „Podobnie dobro ostatecznie pokonuje zło. Normy społeczne oparte są na tych założeniach. Co ciekawe, nigdy nie zostało to przetestowane empirycznie”.

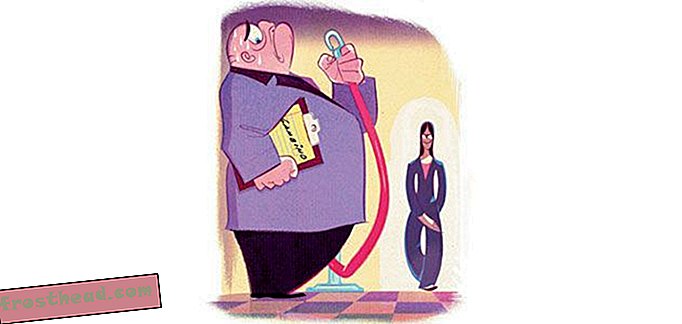

Bingol, który nie był zaangażowany w to badanie, mówi, że badanie podkreśla, w jaki sposób jakość informacji nie zawsze wygrywa, jeśli chodzi o dystrybucję. Badania Oliveiry są zgodne z wcześniejszymi ustaleniami Bingola dotyczącymi wyboru relacji i ilości informacji. W jednym z artykułów stwierdził, że rekomendacja kupca reklamującego dany przedmiot potencjalnemu klientowi miała jeszcze większe znaczenie, gdy klientowi zaoferowano więcej opcji do wyboru.

„Oznacza to, że jeśli sztucznie zwiększysz liczbę wyborów, możesz uzyskać lepsze wyniki przy tym samym„ nacisku marketingowym ”- mówi Bingol. Innymi słowy, osoba przepełniona informacjami jest znacznie łatwiejsza do manipulowania - dla reklamodawców i dostawców fałszywych wiadomości. „Oczywiście nie jest to dzisiaj trudne” - dodaje.

Walter Quattrociocchi, informatyk z IMT School for Advanced Studies Lucca we Włoszech, jest bardziej sceptyczny wobec modelu Oliveiry. „Nadmierne uproszczenie złożonej dynamiki społecznej stojącej za pojawieniem się narracji może być mylące” - mówi Quattrociocchi, który nie był zaangażowany w te badania. Na przykład zastosowany model opierał się na uproszczonym założeniu, że użytkownicy mediów społecznościowych wprowadzają nowe informacje w tym samym tempie, a wszyscy użytkownicy zaczynają z taką samą uwagą.

Choć uznał badanie za interesujące, Quattrociocchi zauważa, że inne badania wykazały, w jaki sposób stronniczość potwierdzeń i inne czynniki poza zakresem modelu Oliveiry mogą znacząco wpłynąć na rozprzestrzenianie się informacji w Internecie.

W przypadku przyszłych badań Oliveira ma nadzieję ulepszyć swój model o niektóre z tych innych faktów, w tym o tym, w jaki sposób stosunek osoby do osoby udostępniającej informacje wpływa na sposób ich przetwarzania oraz prawdopodobieństwo, że ludzie zmienią zdanie po otrzymaniu informacji online, która jest w konflikcie z ich obecne przekonania.

Pod koniec dnia Oliveira uważa, że powstrzymanie fałszywych wiadomości zaczyna się od czytelników. Sugeruje, aby ludzie uważnie czytali to, co udostępniają online, unikali nieprzyjaznych lub przestających obserwować ludzi, aby stworzyć komorę echa online i unikali zakładania, że cokolwiek jest godne zaufania, nawet jeśli ufają osobie, która je udostępnia. „Należy pamiętać, że nasi przyjaciele prawdopodobnie nie są dobrymi redaktorami i kierują się emocjami i uprzedzeniami bardziej niż obiektywizmem i wiarygodnością” - zauważa.

Przeczytaj więc jeszcze raz ten artykuł i sprawdź, skąd pochodzi, zanim klikniesz „udostępnij”.