Nowa sieć neuronowa opracowana przez naukowców z Massachusetts Institute of Technology jest zdolna do zgrubnego przybliżenia twarzy osoby na podstawie wyłącznie fragmentu jej mowy, pracy opublikowanej w raportach arXiv serwera pre-print.

Zespół wyszkolił narzędzie sztucznej inteligencji - algorytm uczenia maszynowego zaprogramowany do „myślenia” podobnie jak ludzki mózg - z pomocą milionów klipów online przechwytujących ponad 100 000 różnych mówców. Nazwana Speech2Face, sieć neuronowa wykorzystała ten zestaw danych do ustalenia powiązań między wskazówkami głosowymi a określonymi rysami twarzy; jak piszą naukowcy w badaniu, wiek, płeć, kształt ust, rozmiar warg, struktura kości, język, akcent, szybkość i wymowa mają wpływ na mechanikę mowy.

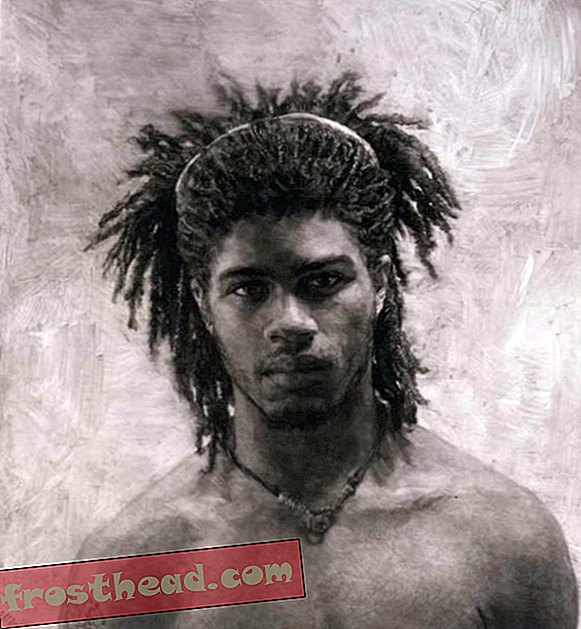

Według Melanie Ehrenkranz z Gizmodo Speech2Face wykorzystuje skojarzenia między wyglądem a mową, aby wygenerować fotorealistyczne renderingi osób z frontem o neutralnych wyrazach. Chociaż obrazy te są zbyt ogólne, aby można je było zidentyfikować jako konkretną osobę, większość z nich dokładnie określa płeć, rasę i wiek mówców.

Co ciekawe, Jackie Snow wyjaśnia dla Fast Company, nowe badanie opiera się nie tylko na wcześniejszych badaniach dotyczących przewidywania wieku i płci na podstawie mowy, ale także uwypukla związki między głosem a „rysami twarzoczaszki”, takimi jak struktura nosa.

Autorzy dodają: „Osiąga się to bez wcześniejszych informacji lub bez dokładnych klasyfikatorów dla tego rodzaju drobnych cech geometrycznych”.

Algorytm ma jednak swoje wady. Jak zauważa Mindy Weisberger na żywo, model ma problemy z analizą odmian języka. Na przykład podczas odtwarzania klipu azjatyckiego mężczyzny mówiącego po chińsku Speech2Face stworzył twarz o właściwej etniczności, ale kiedy nagrano tę samą osobę mówiącą po angielsku, sztuczna inteligencja wygenerowała obraz białego człowieka.

W innych przypadkach mężczyźni o wysokich tonach, w tym dzieci, zostali błędnie zidentyfikowani jako kobiety, co ujawniło uprzedzenia płciowe w powiązaniu niskich tonów z mężczyznami i wysokich tonów z kobietami. Biorąc pod uwagę fakt, że dane szkoleniowe pochodzą w dużej mierze z filmów edukacyjnych opublikowanych na YouTube, badacze dalej podkreślają, że algorytm „nie reprezentuje jednakowo całej populacji świata”.

Według Jane C. Hu Slate'a legalność wykorzystywania filmów z YouTube do badań naukowych jest dość jasna. Takie klipy są uważane za publicznie dostępne informacje; nawet jeśli użytkownik jest chroniony prawami autorskimi do swoich filmów, naukowcy mogą włączyć materiały do swoich eksperymentów w ramach klauzuli „dozwolonego użytku”.

Ale etyka tej praktyki jest mniej prosta. Rozmawiając z Hu, Nickiem Sullivanem, szefem kryptografii w Cloudflare, powiedział, że był zaskoczony, widząc swoje zdjęcie w badaniu zespołu MIT, ponieważ nigdy nie podpisał zrzeczenia się ani nie usłyszał bezpośrednio od badaczy. Chociaż Sullivan mówi Hu, że byłoby „miło” zostać powiadomionym o włączeniu go do bazy danych, przyznaje, że biorąc pod uwagę samą wielkość puli danych, naukowcom trudno byłoby dotrzeć do wszystkich przedstawionych osób.

Jednocześnie Sullivan podsumowuje: „Ponieważ mój obraz i głos zostały wyszczególnione jako przykład w artykule Speech2Face, a nie tylko jako punkt danych w badaniach statystycznych, uprzejmie byłoby skontaktować się z nami, aby poinformować mnie lub poprosić o moją zgodę. ”

Jedną z potencjalnych aplikacji Speech2Face w świecie rzeczywistym jest wykorzystanie modelu do „dołączenia reprezentatywnej twarzy” do połączeń telefonicznych na podstawie głosu mówcy. Snow dodaje, że technologia rozpoznawania głosu jest już stosowana na wielu polach - często bez wyraźnej wiedzy i zgody osób. W ubiegłym roku Chase uruchomił program „Voice ID”, który uczy się rozpoznawać klientów kart kredytowych dzwoniących do banku, podczas gdy instytucje więzienne w całym kraju budują bazy danych „odcisków głosowych” uwięzionych osób.