W filmach nigdy nie słyszysz, jak roboty mówią „co?”

Mimo całego tego niepokoju C-3PO „Gwiezdnych wojen” nigdy nie był zamroczony. Sonny, kluczowy nie-człowiek w „I, Robot” mógł być zdezorientowany tym, kim był, ale nie miał problemów ze zrozumieniem Willa Smitha.

Jednak w prawdziwym życiu maszyny nadal silnie walczą z ludzkim językiem. Jasne, Siri może odpowiedzieć na pytania, jeśli rozpozna wystarczającą liczbę słów w danym zapytaniu. Ale proszenie robota o zrobienie czegoś, czego nie zaprogramowano krok po kroku? Powodzenia z tym.

Częściowym problemem jest to, że my, ludzie, nie jesteśmy bardzo precyzyjni w mowie; kiedy rozmawiamy ze sobą, zwykle nie musimy. Ale poproś robota, aby „podgrzał trochę wody”, a odpowiednia odpowiedź brzmiałaby „Co?” - chyba że nauczył się przetwarzać długi ciąg pytań związanych z tym pozornie prostym czynem. Wśród nich: co to jest woda? Skąd to masz? W co możesz to włożyć? Co oznacza „podgrzewanie”? Jakiego innego przedmiotu potrzebujesz, aby to zrobić? Czy źródło jest w tym pokoju?

Teraz jednak naukowcy z Cornell University podjęli wyzwanie szkolenia robota, aby interpretował to, co nie zostało powiedziane - lub dwuznaczność tego, co zostało powiedziane. Nazywają projekt Tell Me Dave, ukłon w stronę HAL, komputera z kojącym głosem i paranoicznymi tendencjami w filmie „2001: A Space Odyssey”.

Ich robot, wyposażony w kamerę 3D, został zaprogramowany do kojarzenia obiektów z ich możliwościami. Na przykład wie, że kubek jest czymś, czego można użyć do przechowywania wody, do picia lub jako sposób na nalewanie wody do czegoś innego; piec to coś, co może ogrzewać rzeczy, ale także coś, na czym można kłaść rzeczy. Informatycy nazywają technikę uziemienia - pomagając robotom łączyć słowa z przedmiotami i działaniami w prawdziwym świecie.

„Słowa nic nie znaczą dla robota, jeśli nie są ugruntowane w działaniu”, wyjaśnia Ashutosh Saxena, szef zespołu Tell Me Dave. Robot projektu, jak mówi, nauczył się mapować różne frazy, takie jak „podnieś” lub „podnieś” do tej samej akcji.

To duży krok naprzód w komunikacji człowiek-robot, biorąc pod uwagę, jak wiele różnych sposobów możemy opisać proste zadanie.

„Wszystkie roboty, takie jak te do produkcji przemysłowej, samochody samobieżne lub roboty wspomagające, muszą wchodzić w interakcje z ludźmi i interpretować ich nieprecyzyjny język” - powiedział. „Możliwość zrozumienia znaczenia słów z ich kontekstu środowiskowego byłaby natychmiast przydatna dla wszystkich tych robotów”.

Wysiłek grupy

Saxena wraz z doktorantami Dipendrą Misrą i Jaeyongiem Sungiem również zwróciła się do crowdsourcingu, aby zebrać jak najwięcej różnych wariantów języka angielskiego.

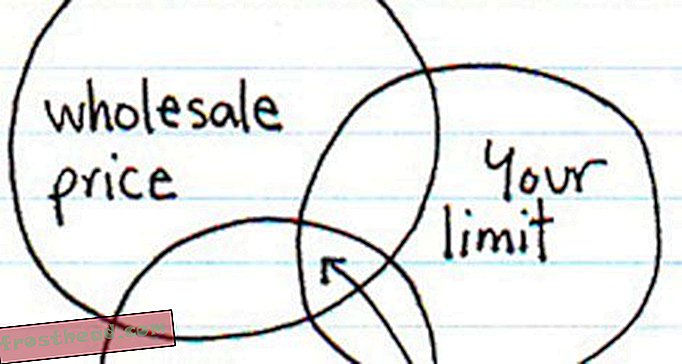

Odwiedzający witrynę Tell Me Dave proszeni są o polecenie wirtualnego robota, aby wykonał określone zadanie, takie jak „Make ramen”. Ponieważ większość ludzi wydaje różne polecenia, prowadząc robota przez cały proces, zespół był w stanie zbierz duże słownictwo związane z tym samym etapem procesu.

Te polecenia, nagrane z różnymi akcentami, są powiązane z przechowywanymi symulacjami wideo różnych zadań. Więc nawet jeśli wyrażenia są różne - „zabierz garnek do pieca” w przeciwieństwie do „włóż garnek do pieca” - maszyna Tell Me Dave może obliczyć prawdopodobieństwo dopasowania do czegoś, co słyszał wcześniej.

W tym momencie robot Tell Me Dave wykonuje wymagane zadania prawie dwie trzecie czasu. Obejmuje to przypadki, w których obiekty są przenoszone w różne miejsca w pokoju lub robot pracuje w innym pomieszczeniu. Czasami jednak robot wciąż nie ma pojęcia: kiedy kazano mu czekać, aż lody zmiękną, „nie mógł wymyślić, co robić”, mówi Saxena.

Mimo to znacznie lepiej wypełnia nieokreślone kroki. Na przykład, gdy nakazano mu „podgrzać wodę w doniczce”, robot zdał sobie sprawę, że najpierw musi przenieść doniczkę do kranu i napełnić ją wodą. Wie również, że po otrzymaniu polecenia podgrzania czegoś może korzystać z kuchenki lub kuchenki mikrofalowej, w zależności od tego, która jest dostępna.

Saxena mówi, że szkolenie robotów Tell Me Dave musi ulec poprawie, zanim będzie można je wykorzystać w rzeczywistych warunkach; mówi, że 64% czasu jest niewystarczające, mówi, zwłaszcza że ludzie rozumieją, co powiedziano 90% czasu.

Saxena i jego zespół zaprezentują swoje algorytmy szkolenia robotów i pokażą, w jaki sposób rozszerzyli ten proces poprzez crowdsourcing, w przyszłym tygodniu na konferencji Science and Systems Robotics na Uniwersytecie Kalifornijskim w Berkeley; podobne badania są prowadzone na University of Washington.

Nie ma wątpliwości, że roboty opanują algorytmy - to tylko kwestia momentu, w którym nastąpi skok z laboratorium na rynek. Następny rok? Raczej nie. Ale w ciągu dekady, gdy duże firmy koncentrują się na wchodzeniu na nowe rynki, takie jak samochody samojezdne, jest całkiem możliwe, że będziemy mogli powiedzieć robotom takim jak Tell Me Dave, aby zaczęli obiad.Powiedz co

Oto najnowsze wiadomości na temat badań nad komunikacją z robotami i za ich pośrednictwem:

- Jaki jest gest „upewnij się, że moje siedzenie jest ciepłe” ?: Mercedes-Benz chce być pierwszą dużą firmą samochodową, która zacznie sprzedawać samochody bez kierowców, być może już w 2020 r., A jego inżynierowie rozpoczęli współpracę z ekspertami robotyki, aby opracować sposoby na ludzi do komunikowania się ze swoimi pojazdami. Jedną z metod przyciągania uwagi jest użycie ręcznych sygnałów, które czujniki samochodu mogą zrozumieć. Eksperci twierdzą, że odpowiednim gestem możesz wezwać zaparkowany samochód, by cię odebrał.

- Wreszcie roboty pomocnicze dla mechaników: w Audi pomocnicy robotów zostaną wkrótce wysłani do mechaniki firmy na całym świecie. Roboty zostaną wyposażone w kamery 3D kontrolowane przez specjalistę z zewnątrz, który może przeprowadzać trudne prace naprawcze przez osoby pracujące przy samochodach.

- Usprawnienie Siri: Według raportu Wired firma Apple zaczęła zatrudniać najlepszych ekspertów od rozpoznawania mowy, kiedy zaczyna koncentrować się na koncepcji sieci neuronowych, dzięki czemu maszyny uczą się słów poprzez budowanie połączeń i naśladowanie funkcjonowania neuronów w ludzkim mózgu.

- Robot musi pojechać na pokaz sztuki: jeszcze w tym miesiącu robot rozpocznie autostop w całej Kanadzie. Nazywany HitchBOT, został opisany jako eksperyment społeczno-artystyczny w ramach projektu artystycznego. Celem jest sprawdzenie, czy HitchBOT zdoła przejść z Halifax do galerii w całym kraju w Kolumbii Brytyjskiej. Nie będzie w stanie poruszać się samodzielnie, ale będzie wyposażony w mikrofon i kamerę, które pozwolą mu wykryć ruch i mowę. Będzie także mógł odpowiadać na pytania przy użyciu bazy danych z Wikipedii.