Wszyscy słyszeli o nowych postępach w sztucznej inteligencji, a zwłaszcza o uczeniu maszynowym. Słyszeliście również utopijne lub apokaliptyczne prognozy dotyczące tego, co oznaczają te postępy. Zostali zabrani, aby zapowiadać nieśmiertelność lub koniec świata, a wiele z tych możliwości napisano. Jednak najbardziej wyrafinowane AI wciąż nie są w stanie rozwiązać problemów, które czterolatki z łatwością sobie radzą. Pomimo imponującej nazwy, sztuczna inteligencja w dużej mierze składa się z technik wykrywania wzorców statystycznych w dużych zbiorach danych. Ludzkie uczenie się ma znacznie więcej.

Skąd możemy wiedzieć tyle o otaczającym nas świecie? Uczymy się ogromnej ilości, nawet gdy jesteśmy małymi dziećmi; czterolatki już wiedzą o roślinach, zwierzętach i maszynach; pragnienia, przekonania i emocje; nawet dinozaury i statki kosmiczne.

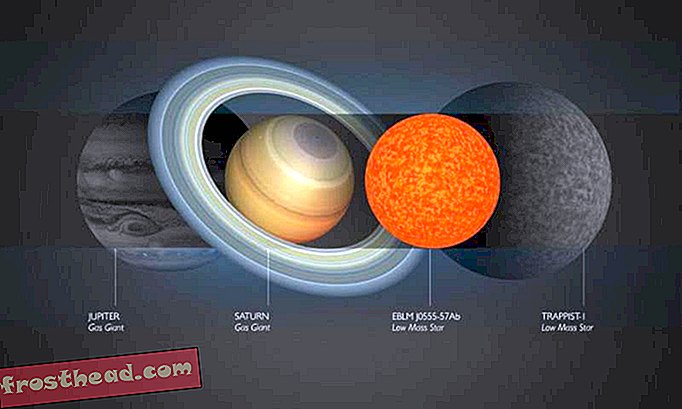

Nauka rozszerzyła naszą wiedzę o świecie na niewyobrażalnie duże i nieskończenie małe, na brzeg wszechświata i początek czasu. Korzystamy z tej wiedzy, aby tworzyć nowe klasyfikacje i prognozy, wyobrażać sobie nowe możliwości i wprowadzać nowe rzeczy na świecie. Ale wszystko, co dociera do każdego z nas ze świata, to strumień fotonów uderzających w nasze siatkówki i zaburzenia powietrza w naszych bębenkach bębenkowych. Jak uczymy się tak wiele o świecie, skoro posiadane przez nas dowody są tak ograniczone? Jak to wszystko zrobić z kilkoma kilogramami szarej mazi, która siedzi za naszymi oczami?

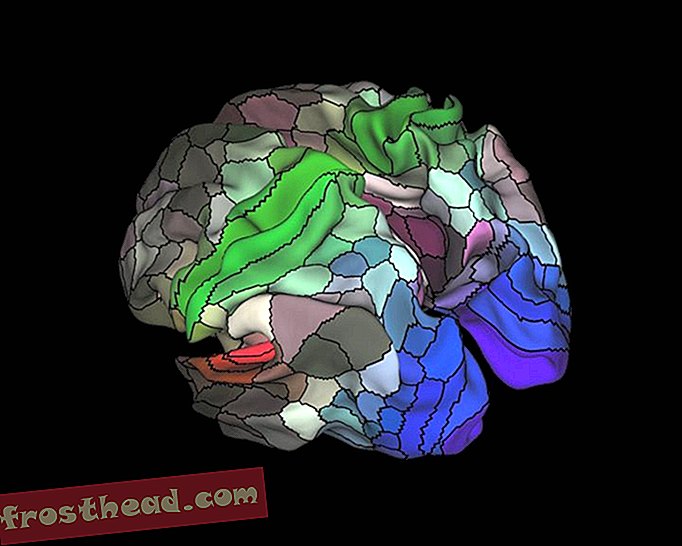

Najlepszą jak dotąd odpowiedzią jest to, że nasze mózgi wykonują obliczenia na konkretnych, szczególnie niechlujnych danych docierających do naszych zmysłów, a te obliczenia dają dokładne odwzorowanie świata. Przedstawienia wydają się być uporządkowane, abstrakcyjne i hierarchiczne; obejmują one postrzeganie trójwymiarowych obiektów, gramatyki leżące u podstaw języka i zdolności umysłowe, takie jak „teoria umysłu”, która pozwala nam zrozumieć, co myślą inni ludzie. Przedstawienia te pozwalają nam tworzyć szeroki zakres nowych prognoz i wyobrażać sobie wiele nowych możliwości w wyraźnie twórczy ludzki sposób.

Ten rodzaj uczenia się nie jest jedynym rodzajem inteligencji, ale jest szczególnie ważny dla ludzi. I to jest rodzaj inteligencji, która jest specjalnością małych dzieci. Chociaż dzieci są dramatycznie złe w planowaniu i podejmowaniu decyzji, są najlepszymi uczniami we wszechświecie. Znaczna część procesu przekształcania danych w teorie odbywa się przed ukończeniem piątego roku życia.

Od czasów Arystotelesa i Platona istniały dwa podstawowe sposoby rozwiązania problemu tego, w jaki sposób wiemy, co wiemy, i są one nadal głównymi podejściami w uczeniu maszynowym. Arystoteles podszedł do problemu od podstaw: Zacznij od zmysłów - strumienia fotonów i wibracji powietrza (lub pikseli lub próbek dźwięku obrazu cyfrowego lub nagrania) - i sprawdź, czy możesz wyodrębnić z nich wzory. Takie podejście było kontynuowane przez takich klasycznych stowarzyszeń, jak filozofowie David Hume i JS Mill, a później przez psychologów behawioralnych, takich jak Pavlov i BF Skinner. W tym ujęciu abstrakcyjność i hierarchiczna struktura przedstawień jest złudzeniem, a przynajmniej epifenomenem. Całą pracę można wykonać przez wykrywanie skojarzeń i wzorców - zwłaszcza jeśli jest wystarczająca ilość danych.

Możliwe umysły: 25 sposobów patrzenia na AI

Świat naukowy John Brockman gromadzi dwadzieścia pięć najważniejszych umysłów naukowych, ludzi, którzy przez większość swojej kariery myśleli o sztucznej inteligencji w terenie, w celu niezrównanego badania okrągłego stołu na temat umysłu, myślenia, inteligencji i tego, co to znaczy bądź człowiekiem.

KupowaćZ czasem nastąpiła huśtawka między tym oddolnym podejściem do tajemnicy uczenia się a alternatywnym podejściem Platona, odgórnym. Może zdobywamy abstrakcyjną wiedzę z konkretnych danych, ponieważ już dużo wiemy, a zwłaszcza dlatego, że dzięki ewolucji mamy już szereg podstawowych abstrakcyjnych koncepcji. Podobnie jak naukowcy, możemy wykorzystać te koncepcje do sformułowania hipotez na temat świata. Następnie zamiast próbować wyodrębnić wzorce z surowych danych, możemy przewidzieć, jak powinny wyglądać dane, jeśli te hipotezy są słuszne. Wraz z Platonem tacy „racjonalistyczni” filozofowie i psychologowie, jak Kartezjusz i Noam Chomsky, przyjęli to podejście.

Oto codzienny przykład ilustrujący różnicę między dwiema metodami: rozwiązanie problemu zarazy spamowej. Dane składają się z długiej, nieposortowanej listy wiadomości w skrzynce odbiorczej. W rzeczywistości niektóre z tych wiadomości są autentyczne, a niektóre są spamem. Jak wykorzystać dane do rozróżnienia między nimi?

Najpierw rozważ technikę oddolną. Zauważasz, że wiadomości spamowe mają zwykle szczególne cechy: długą listę adresatów, pochodzenie w Nigerii, odniesienia do nagród za milion dolarów lub Viagrę. Problem polega na tym, że doskonale przydatne wiadomości mogą mieć również te funkcje. Jeśli spojrzysz na wystarczającą liczbę przykładów spamu i wiadomości spamowych, możesz zauważyć nie tylko, że wiadomości spamowe mają te funkcje, ale że funkcje te łączą się w określony sposób (Nigeria plus milion dolarów oznacza kłopoty). W rzeczywistości mogą istnieć pewne subtelne korelacje wyższego poziomu, które odróżniają wiadomości spamowe od przydatnych - na przykład szczególny wzór błędów pisowni i adresów IP. Jeśli wykryjesz te wzorce, możesz odfiltrować spam.

Robią to oddolne techniki uczenia maszynowego. Uczeń otrzymuje miliony przykładów, każdy z pewnym zestawem funkcji i każdy oznaczony jako spam (lub inna kategoria) lub nie. Komputer może wyodrębnić wzór cech, który je rozróżnia, nawet jeśli jest dość subtelny.

Co powiesz na podejście odgórne? Dostaję e-mail od redaktora Journal of Clinical Biology . Odnosi się do jednego z moich artykułów i mówi, że chcieliby opublikować artykuł przeze mnie. Bez Nigerii, bez Viagry, bez miliona dolarów; wiadomość e-mail nie ma żadnych cech spamu. Ale korzystając z tego, co już wiem, i myśląc w abstrakcyjny sposób o procesie produkującym spam, mogę dowiedzieć się, że ten e-mail jest podejrzany:

1. Wiem, że spamerzy próbują pozyskiwać pieniądze od ludzi, odwołując się do ludzkiej chciwości.

2. Wiem również, że legalne czasopisma „open access” zaczęły pokrywać koszty, pobierając opłatę od autorów zamiast abonentów, i że nie praktykuję niczego takiego jak biologia kliniczna.

Połącz to wszystko, a ja mogę przedstawić nową hipotezę dotyczącą tego, skąd pochodzi ten e-mail. Został zaprojektowany, aby nakłonić naukowców do płacenia za „opublikowanie” artykułu w fałszywym czasopiśmie. Wiadomość e-mail była wynikiem tego samego podejrzanego procesu, co inne wiadomości spamowe, mimo że nie przypominała ich. Mogę wyciągnąć ten wniosek z jednego przykładu i mogę dalej testować moją hipotezę, wykraczając poza wszystko w samym e-mailu, przeglądając „edytora”.

W kategoriach komputerowych zacząłem od „modelu generatywnego”, który zawiera abstrakcyjne pojęcia, takie jak chciwość i oszustwo, i opisuje proces, który powoduje oszustwa e-mailowe. To pozwala mi rozpoznać klasyczny nigeryjski spam e-mail, ale pozwala mi także wyobrazić sobie wiele różnych rodzajów spamu. Kiedy dostaję e-mail z dziennika, mogę pracować wstecz: „Wydaje się, że to rodzaj poczty, która pochodzi z procesu generowania spamu”.

Nowe emocje związane z AI pojawiają się, ponieważ badacze AI opracowali ostatnio potężne i skuteczne wersje obu tych metod uczenia się. Ale w samych metodach nie ma nic nowego.

Głębokie uczenie się oddolne

W latach osiemdziesiątych informatycy opracowali genialny sposób na wykrycie przez komputery wzorców w danych: architektury połączenia lub sieci neuronowej (część „neuronowa” była i nadal jest metaforyczna). Podejście to wpadło w zastój w latach 90., ale ostatnio zostało odnowione dzięki potężnym metodom „głębokiego uczenia się”, takim jak DeepMind Google.

Na przykład możesz podać programowi dogłębnego uczenia się kilka zdjęć internetowych z napisem „kot”, inne - „dom” i tak dalej. Program może wykryć wzorce różnicujące dwa zestawy obrazów i wykorzystać te informacje do poprawnego oznakowania nowych obrazów. Niektóre rodzaje uczenia maszynowego, zwane uczeniem się bez nadzoru, mogą wykrywać wzorce w danych bez żadnych etykiet; po prostu szukają grup cech - to, co naukowcy nazywają analizą czynnikową. W maszynach do głębokiego uczenia się procesy te są powtarzane na różnych poziomach. Niektóre programy mogą nawet odkryć odpowiednie funkcje na podstawie surowych danych pikseli lub dźwięków; komputer może rozpocząć od wykrycia wzorów na surowym obrazie, które odpowiadają krawędziom i liniom, a następnie znajduje wzory w tych wzorach, które odpowiadają ścianom i tak dalej.

Kolejną techniką oddolną z długą historią jest nauka wzmacniająca. W latach 50. BF Skinner, opierając się na pracy Johna Watsona, słynnie zaprogramował gołębie do wykonywania skomplikowanych działań - nawet kierując wystrzeliwane w powietrze pociski do swoich celów (niepokojące echo niedawnej sztucznej inteligencji), nadając im szczególny harmonogram nagród i kar . Istotną ideą było to, że działania, które zostały nagrodzone, będą powtarzane, a te, które zostaną ukarane, nie zostaną wykonane, dopóki pożądane zachowanie nie zostanie osiągnięte. Nawet w czasach Skinnera ten prosty proces, powtarzany w kółko, może prowadzić do złożonych zachowań. Komputery są zaprojektowane do wykonywania prostych operacji w skali, która przewyższa ludzką wyobraźnię, a systemy obliczeniowe mogą uczyć się w ten sposób niezwykle złożonych umiejętności.

Na przykład naukowcy z DeepMind firmy Google zastosowali połączenie uczenia głębokiego i uczenia wzmacniającego, aby nauczyć komputer grać w gry wideo Atari. Komputer nic nie wiedział o tym, jak działają gry. Zaczęło się od losowego działania i otrzymywało informacje tylko o tym, jak ekran wyglądał w każdej chwili i jak dobrze go zdobył. Dogłębne uczenie się pomogło zinterpretować funkcje na ekranie, a uczenie się przez wzmacnianie nagrodziło system za wyższe wyniki. Komputer bardzo dobrze radził sobie z graniem w kilka gier, ale także całkowicie bombardował inne, które ludzie równie łatwo opanowali.

Podobna kombinacja uczenia głębokiego i uczenia się wspomagającego pozwoliła na sukces AlphaZero DeepMind, programu, który zdołał pokonać ludzi zarówno w szachach, jak i w Go, wyposażonego tylko w podstawową wiedzę o zasadach gry i pewne możliwości planowania. AlphaZero ma jeszcze jedną interesującą funkcję: działa, grając przeciwko sobie w setki milionów gier. Czyniąc to, przycina błędy, które doprowadziły do strat, a także powtarza i opracowuje strategie, które doprowadziły do zwycięstw. Takie systemy i inne, obejmujące techniki zwane generatywnymi sieciami przeciwnymi, generują dane, a także obserwują dane.

Gdy masz moc obliczeniową do zastosowania tych technik do bardzo dużych zestawów danych lub milionów wiadomości e-mail, obrazów na Instagramie lub nagrań głosowych, możesz rozwiązać problemy, które wcześniej wydawały się bardzo trudne. To jest źródłem wielu emocji w informatyce. Ale warto pamiętać, że te problemy - jak rozpoznanie, że obraz jest kotem lub mówionym słowem to Siri - są banalne dla ludzkiego malucha. Jednym z najciekawszych odkryć informatyki jest to, że łatwe dla nas problemy (takie jak identyfikacja kotów) są trudne dla komputerów - znacznie trudniejsze niż gra w szachy lub Go. Komputery potrzebują milionów przykładów, aby kategoryzować obiekty, które możemy skategoryzować za pomocą zaledwie kilku. Te oddolne systemy można uogólniać na nowe przykłady; mogą oznaczyć nowy obraz jako kota dość dokładnie. Ale robią to w sposób zupełnie inny niż uogólnienie ludzi. Niektóre obrazy prawie identyczne z obrazami kotów nie będą w ogóle identyfikowane przez nas jako koty. Inne, które wyglądają jak przypadkowe rozmycie, będą.

Modele Bayesowskie z góry na dół

Podejście odgórne odegrało dużą rolę we wczesnej sztucznej inteligencji, a także w 2000 roku przeżyło ożywienie, w postaci modeli probabilistycznych lub bayesowskich.

Wczesne próby zastosowania tego podejścia napotkały dwa rodzaje problemów. Po pierwsze, większość wzorów dowodów można w zasadzie wyjaśnić wieloma różnymi hipotezami: możliwe, że wiadomość e-mail z mojego dziennika jest autentyczna, po prostu nie wydaje się prawdopodobna. Po drugie, skąd biorą się pojęcia, które wykorzystują modele generatywne? Platon i Chomsky powiedzieli, że urodziłeś się z nimi. Ale jak wyjaśnić, w jaki sposób uczymy się najnowszych koncepcji nauki? Albo jak nawet małe dzieci rozumieją dinozaury i statki rakietowe?

Modele Bayesowskie łączą modele generatywne i testowanie hipotez z teorią prawdopodobieństwa i rozwiązują te dwa problemy. Model bayesowski pozwala obliczyć, jak prawdopodobne jest, że konkretna hipoteza jest prawdziwa, biorąc pod uwagę dane. Dokonując drobnych, ale systematycznych poprawek w modelach, które już mamy, i testując je pod kątem danych, czasami możemy tworzyć nowe koncepcje i modele ze starych. Ale te zalety są równoważone przez inne problemy. Techniki bayesowskie mogą pomóc ci wybrać, która z dwóch hipotez jest bardziej prawdopodobna, ale prawie zawsze istnieje ogromna liczba możliwych hipotez i żaden system nie może skutecznie rozpatrzyć ich wszystkich. Jak decydujesz, które hipotezy są warte przetestowania?

Brenden Lake z NYU i współpracownicy zastosowali tego rodzaju metody odgórne, aby rozwiązać inny problem, który jest łatwy dla ludzi, ale niezwykle trudny dla komputerów: rozpoznawanie nieznanych odręcznych postaci. Spójrz na znak z japońskiego zwoju. Nawet jeśli nigdy wcześniej go nie widziałeś, prawdopodobnie możesz stwierdzić, czy jest podobny do postaci na innym japońskim zwoju lub różny od niej. Prawdopodobnie możesz go narysować, a nawet zaprojektować fałszywą japońską postać na podstawie tego, który widzisz - takiego, który będzie wyglądał zupełnie inaczej niż postać koreańska lub rosyjska.

Metodą oddolną do rozpoznawania odręcznych znaków jest podanie komputerowi tysięcy przykładów każdego z nich i pozwolenie mu wyciągnąć najistotniejsze cechy. Zamiast tego Lake i in. dał programowi ogólny model rysowania postaci: udar przesuwa się w prawo lub w lewo; po ukończeniu jednego zaczynasz inny; i tak dalej. Gdy program zobaczył określoną postać, mógł wywnioskować sekwencję ruchów, które najprawdopodobniej do niej doprowadziły - tak samo, jak doszedłem do wniosku, że proces spamowania prowadzi do mojej wątpliwej wiadomości e-mail. Następnie może ocenić, czy nowy znak prawdopodobnie wyniknie z tej sekwencji, czy z innej, i może wytworzyć podobny zestaw pociągnięć. Program działał znacznie lepiej niż program dogłębnego uczenia się zastosowany do dokładnie tych samych danych i ściśle odzwierciedlał wydajność ludzi.

Te dwa podejścia do uczenia maszynowego mają uzupełniające się zalety i wady. W podejściu oddolnym program na początku nie wymaga dużej wiedzy, ale potrzebuje dużej ilości danych i może uogólniać tylko w ograniczonym zakresie. W podejściu odgórnym program może uczyć się na podstawie zaledwie kilku przykładów i dokonywać znacznie szerszych i bardziej różnorodnych uogólnień, ale na początek trzeba w nim zbudować znacznie więcej. Wielu badaczy próbuje obecnie połączyć oba podejścia, wykorzystując głębokie uczenie się w celu wdrożenia wnioskowania bayesowskiego.

Niedawny sukces sztucznej inteligencji jest częściowo wynikiem rozszerzenia tych starych pomysłów. Ale ma to więcej wspólnego z faktem, że dzięki Internetowi mamy znacznie więcej danych, a dzięki Prawu Moore'a mamy znacznie większą moc obliczeniową do zastosowania do tych danych. Co więcej, nie doceniono faktu, że dane, które mamy, zostały już posortowane i przetworzone przez ludzi. Zdjęcia kotów publikowane w Internecie to kanoniczne zdjęcia kotów - zdjęcia, które ludzie wybrali już jako „dobre” zdjęcia. Tłumacz Google działa, ponieważ wykorzystuje miliony ludzkich tłumaczeń i uogólnia je na nowy fragment tekstu, zamiast autentycznie rozumieć same zdania.

Ale naprawdę niezwykłą rzeczą w ludzkich dzieciach jest to, że w jakiś sposób łączą najlepsze cechy każdego podejścia, a następnie wykraczają poza nie. W ciągu ostatnich piętnastu lat programiści badali sposób, w jaki dzieci uczą się struktury z danych. Czterolatki mogą uczyć się, biorąc tylko jeden lub dwa przykłady danych, tak jak robi to system odgórny, i uogólniając bardzo różne koncepcje. Mogą również uczyć się nowych koncepcji i modeli na podstawie samych danych, tak jak robi to system oddolny.

Na przykład w naszym laboratorium dajemy małym dzieciom „wykrywacz blicket” - nową maszynę do wymyślenia, której nigdy wcześniej nie widziały. To pudełko, które się świeci i odtwarza muzykę, gdy umieścisz na nim określone przedmioty, ale nie inne. Dajemy dzieciom tylko jeden lub dwa przykłady działania maszyny, pokazując, że, powiedzmy, dwa czerwone bloki sprawiają, że jedzie, podczas gdy kombinacja zielono-żółta nie. Nawet osiemnastomiesięczne dzieci natychmiast odkrywają ogólną zasadę, że dwa przedmioty muszą być takie same, aby je odejść, i uogólniają tę zasadę na nowe przykłady: na przykład wybiorą dwa obiekty, które mają taki sam kształt do zrobienia maszyna działa. W innych eksperymentach pokazaliśmy, że dzieci mogą nawet dowiedzieć się, że jakaś ukryta niewidzialna właściwość powoduje, że maszyna się porusza lub że działa na jakiejś abstrakcyjnej zasadzie logicznej.

Możesz to również pokazać w codziennej nauce dzieci. Małe dzieci szybko uczą się abstrakcyjnych, intuicyjnych teorii biologii, fizyki i psychologii, podobnie jak dorośli naukowcy, nawet przy stosunkowo niewielkiej ilości danych.

Niezwykłe osiągnięcia w zakresie uczenia maszynowego najnowszych systemów sztucznej inteligencji, zarówno od dołu do góry, jak i z góry na dół, mają miejsce w wąskiej i dobrze zdefiniowanej przestrzeni hipotez i pojęć - precyzyjny zestaw elementów gry i ruchów, z góry określony zestaw obrazów . Z kolei dzieci i naukowcy czasami zmieniają swoje koncepcje w radykalny sposób, dokonując zmian paradygmatu, a nie tylko modyfikując koncepcje, które już mają.

Czterolatki natychmiast rozpoznają koty i rozumieją słowa, ale mogą także tworzyć twórcze i zaskakujące nowe wnioski, które wykraczają daleko poza ich doświadczenie. Mój własny wnuk niedawno wyjaśnił na przykład, że jeśli dorosły chce ponownie zostać dzieckiem, powinien spróbować nie jeść zdrowych warzyw, ponieważ zdrowe warzywa powodują, że dziecko staje się dorosłe. Tego rodzaju hipoteza, prawdopodobna, której żaden dorosły nigdy nie bawi, jest charakterystyczna dla małych dzieci. W rzeczywistości, moi koledzy i ja systematycznie pokazujemy, że przedszkolaki lepiej wymyślają mało prawdopodobne hipotezy niż starsze dzieci i dorośli. Prawie nie mamy pojęcia, jak tego rodzaju kreatywne uczenie się i innowacje są możliwe.

Jednak spojrzenie na to, co robią dzieci, może dać programistom przydatne wskazówki na temat kierunków uczenia się komputera. Szczególnie uderzające są dwie cechy uczenia się dzieci. Dzieci są aktywnymi uczniami; nie tylko pasywnie pochłaniają dane, jak AI. Tak jak eksperymentują naukowcy, dzieci mają wewnętrzną motywację do wydobywania informacji z otaczającego ich świata poprzez niekończącą się zabawę i eksplorację. Ostatnie badania pokazują, że to badanie jest bardziej systematyczne niż się wydaje i jest dobrze dostosowane do znalezienia przekonujących dowodów na poparcie formułowania hipotez i wyboru teorii. Budowanie ciekawości w maszynach i umożliwienie im aktywnej interakcji ze światem może być drogą do bardziej realistycznego i szeroko zakrojonego uczenia się.

Po drugie, dzieci, w przeciwieństwie do istniejących sztucznej inteligencji, są uczniami społecznymi i kulturowymi. Ludzie nie uczą się w izolacji, ale korzystają z nagromadzonej mądrości poprzednich pokoleń. Ostatnie badania pokazują, że nawet przedszkolaki uczą się poprzez naśladowanie i słuchanie świadectwa innych. Ale nie tylko biernie słuchają swoich nauczycieli. Zamiast tego przyjmują informacje od innych w niezwykle subtelny i wrażliwy sposób, dokonując złożonych wniosków na temat tego, skąd pochodzą informacje i ich wiarygodności oraz systematycznie integrując własne doświadczenia z tym, co słyszą.

„Sztuczna inteligencja” i „uczenie maszynowe” brzmią przerażająco. I pod pewnymi względami są. Systemy te są wykorzystywane na przykład do kontrolowania broni i naprawdę powinniśmy się tego bać. Mimo to naturalna głupota może siać o wiele więcej spustoszenia niż sztuczna inteligencja; my, ludzie, będziemy musieli być znacznie mądrzejsi niż w przeszłości, aby właściwie regulować nowe technologie. Ale nie ma wiele podstaw do apokaliptycznej lub utopijnej wizji zastępowania ludzi przez AI. Dopóki nie rozwiążemy podstawowego paradoksu uczenia się, najlepsza sztuczna inteligencja nie będzie w stanie konkurować z przeciętnym czterolatkiem.

Z nadchodzącej kolekcji MOŻLIWE UMYSŁY: 25 sposobów patrzenia na AI, pod redakcją John Brockman. Wydane w porozumieniu z Penguin Press, członkiem Penguin Random House LLC. Prawa autorskie © 2019 John Brockman.